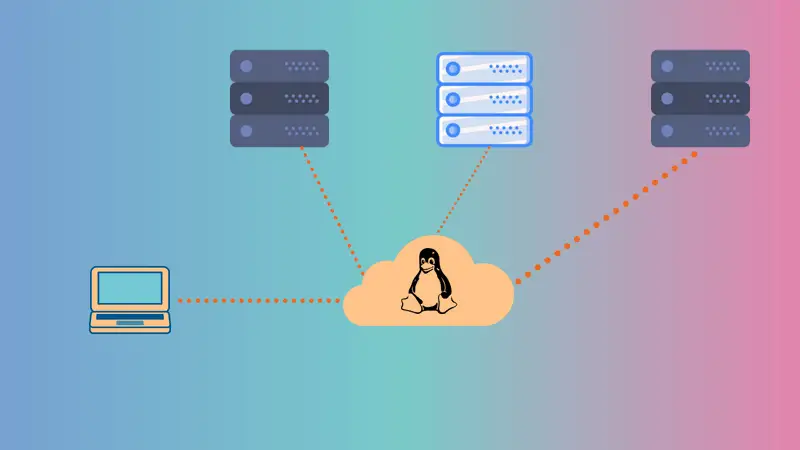

Panduan ini memberikan langkah-langkah untuk mengkonfigurasi load balancing pada VPS Linux. Load balancing mendistribusikan lalu lintas jaringan di beberapa server, meningkatkan ketersediaan dan skalabilitas aplikasi. Panduan ini mencakup konfigurasi load balancer, server backend, dan pengujian.

Memahami Konsep Dasar Load Balancing

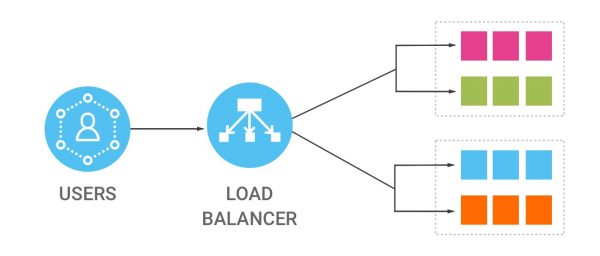

Load balancing, pada intinya, adalah praktik mendistribusikan lalu lintas jaringan atau aplikasi di beberapa server. Pendekatan ini sangat penting dalam lingkungan server modern, terutama ketika berhadapan dengan aplikasi web atau layanan yang mengalami lalu lintas tinggi. Alih-alih membebani satu server dengan semua permintaan, load balancing memastikan bahwa beban kerja didistribusikan secara merata, sehingga mencegah satu server menjadi kewalahan dan menyebabkan gangguan layanan. Dengan demikian, load balancing meningkatkan ketersediaan dan keandalan aplikasi, memastikan bahwa pengguna dapat mengakses layanan tanpa gangguan.

Selain itu, load balancing juga meningkatkan skalabilitas. Ketika permintaan pengguna meningkat, load balancer dapat dengan mudah mengarahkan lalu lintas ke server tambahan, sehingga memungkinkan aplikasi untuk menangani peningkatan beban tanpa penurunan kinerja. Ini sangat penting untuk bisnis yang mengalami pertumbuhan atau lonjakan lalu lintas yang tidak terduga. Dengan kata lain, load balancing memungkinkan aplikasi untuk beradaptasi dengan perubahan permintaan, memastikan bahwa aplikasi tetap responsif dan efisien.

Ada beberapa algoritma load balancing yang berbeda, masing-masing dengan kelebihan dan kekurangannya sendiri. Algoritma round-robin, misalnya, mendistribusikan permintaan secara berurutan ke setiap server dalam daftar. Ini adalah pendekatan yang sederhana dan mudah diimplementasikan, tetapi mungkin tidak ideal jika server memiliki kapasitas yang berbeda. Di sisi lain, algoritma least connection mengarahkan permintaan ke server dengan koneksi aktif paling sedikit, yang dapat menghasilkan distribusi beban yang lebih merata. Selain itu, algoritma least response time mengarahkan permintaan ke server dengan waktu respons tercepat, yang dapat meningkatkan kinerja aplikasi secara keseluruhan. Oleh karena itu, pemilihan algoritma load balancing yang tepat bergantung pada kebutuhan spesifik aplikasi dan infrastruktur yang mendasarinya.

Selain algoritma, load balancer juga dapat diklasifikasikan berdasarkan lapisan jaringan tempat mereka beroperasi. Load balancer lapisan 4 beroperasi pada lapisan transport, membuat keputusan berdasarkan alamat IP dan port. Load balancer ini biasanya digunakan untuk aplikasi yang tidak memerlukan pemeriksaan konten yang mendalam. Sebaliknya, load balancer lapisan 7 beroperasi pada lapisan aplikasi, memungkinkan mereka untuk membuat keputusan berdasarkan konten permintaan, seperti header HTTP atau URL. Load balancer ini lebih fleksibel dan dapat digunakan untuk aplikasi yang lebih kompleks, tetapi juga lebih kompleks untuk dikonfigurasi. Oleh karena itu, pemilihan jenis load balancer yang tepat bergantung pada persyaratan aplikasi dan tingkat kontrol yang diperlukan.

Terakhir, penting untuk dicatat bahwa load balancing bukan solusi sekali pakai. Ini adalah proses berkelanjutan yang memerlukan pemantauan dan penyesuaian yang berkelanjutan. Seiring dengan perubahan lalu lintas dan persyaratan aplikasi, konfigurasi load balancer mungkin perlu disesuaikan untuk memastikan kinerja dan ketersediaan yang optimal. Dengan demikian, pemahaman yang menyeluruh tentang konsep dasar load balancing dan berbagai opsi konfigurasi sangat penting untuk mengelola infrastruktur server yang andal dan efisien.

Mengkonfigurasi Nginx Sebagai Load Balancer

Nginx: Menyeimbangkan beban, memaksimalkan kinerja.

Mengonfigurasi Nginx sebagai load balancer melibatkan pengaturan Nginx untuk mendistribusikan lalu lintas jaringan di beberapa server backend. Ini meningkatkan ketersediaan, skalabilitas, dan keandalan aplikasi web. Prosesnya melibatkan konfigurasi Nginx untuk bertindak sebagai titik masuk tunggal, dan kemudian mengarahkan permintaan masuk ke server backend yang berbeda berdasarkan algoritma load balancing yang dipilih.

Pemantauan Dan Pemeliharaan Load Balancer Nginx

Setelah Anda berhasil menyiapkan Nginx sebagai load balancer, perjalanan Anda tidak berakhir di sana. Sebaliknya, ini menandai awal dari fase penting: pemantauan dan pemeliharaan. Bayangkan load balancer Anda sebagai jantung dari infrastruktur web Anda; ia harus berdetak dengan stabil dan efisien untuk menjaga semuanya berjalan lancar. Oleh karena itu, pemantauan yang cermat menjadi sangat penting. Anda perlu terus-menerus mengawasi berbagai metrik, seperti lalu lintas yang masuk, respons server, dan kesehatan server backend. Dengan memantau metrik ini, Anda dapat mengidentifikasi potensi masalah sebelum mereka meningkat menjadi masalah besar. Misalnya, lonjakan lalu lintas yang tiba-tiba dapat mengindikasikan serangan DDoS, sementara waktu respons server yang lambat dapat menunjukkan masalah dengan salah satu server backend Anda.

Selain itu, pemantauan tidak hanya tentang mengidentifikasi masalah; ini juga tentang mengoptimalkan kinerja. Dengan menganalisis data yang dikumpulkan, Anda dapat membuat keputusan yang tepat tentang cara mengalokasikan sumber daya dengan lebih baik. Misalnya, jika Anda melihat bahwa satu server backend secara konsisten lebih banyak dimuat daripada yang lain, Anda dapat menyesuaikan konfigurasi load balancer untuk mendistribusikan lalu lintas secara lebih merata. Selain itu, pemantauan dapat membantu Anda mengidentifikasi tren dan pola yang dapat menginformasikan perencanaan kapasitas Anda. Dengan memahami bagaimana lalu lintas Anda berfluktuasi dari waktu ke waktu, Anda dapat memastikan bahwa Anda memiliki sumber daya yang tepat untuk menangani permintaan di masa mendatang.

Namun, pemantauan hanyalah satu bagian dari teka-teki. Pemeliharaan sama pentingnya untuk memastikan bahwa load balancer Anda tetap sehat dan andal. Ini melibatkan tugas-tugas seperti memperbarui Nginx ke versi terbaru, menerapkan patch keamanan, dan mengelola konfigurasi. Pembaruan rutin sangat penting untuk mengatasi kerentanan keamanan dan memastikan bahwa Anda memanfaatkan fitur dan peningkatan kinerja terbaru. Selain itu, Anda harus secara teratur meninjau konfigurasi load balancer Anda untuk memastikan bahwa itu masih sesuai dengan kebutuhan Anda. Seiring pertumbuhan aplikasi Anda, Anda mungkin perlu menyesuaikan konfigurasi untuk mengakomodasi perubahan lalu lintas dan persyaratan server backend.

Selanjutnya, pemeliharaan juga mencakup pemantauan log dan penanganan kesalahan. Log Nginx dapat memberikan wawasan berharga tentang bagaimana load balancer Anda beroperasi. Dengan menganalisis log ini, Anda dapat mengidentifikasi kesalahan, masalah kinerja, dan potensi masalah keamanan. Selain itu, Anda harus memiliki strategi yang jelas untuk menangani kesalahan. Misalnya, jika server backend menjadi tidak tersedia, load balancer Anda harus dapat mengalihkan lalu lintas ke server yang sehat lainnya. Dengan memiliki strategi penanganan kesalahan yang kuat, Anda dapat meminimalkan dampak pemadaman dan memastikan bahwa aplikasi Anda tetap tersedia bagi pengguna Anda.

Terakhir, ingatlah bahwa pemantauan dan pemeliharaan adalah proses yang berkelanjutan. Tidak ada solusi sekali pakai untuk memastikan bahwa load balancer Anda tetap sehat dan andal. Sebaliknya, Anda harus terus memantau, memelihara, dan mengoptimalkan konfigurasi Anda untuk memenuhi kebutuhan aplikasi Anda yang terus berkembang. Dengan melakukan ini, Anda dapat memastikan bahwa load balancer Nginx Anda terus berfungsi sebagai tulang punggung infrastruktur web Anda, memberikan kinerja yang andal dan efisien untuk pengguna Anda.

Mengkonfigurasi Nginx Sebagai Load Balancer TCP/UDP

Mari kita selami dunia konfigurasi Nginx sebagai load balancer TCP/UDP, sebuah ranah di mana fleksibilitas dan efisiensi bertemu. Bayangkan Nginx bukan hanya sebagai server web, tetapi sebagai konduktor yang terampil, mengarahkan lalu lintas jaringan dengan presisi dan keanggunan. Dalam konteks ini, kita beralih dari penanganan permintaan HTTP tradisional ke dunia protokol TCP dan UDP yang lebih luas. Ini berarti bahwa Nginx dapat mendistribusikan koneksi dari berbagai layanan, mulai dari server database hingga aplikasi streaming, memastikan bahwa tidak ada satu server pun yang kewalahan.

Pertama-tama, kita perlu memahami bahwa konfigurasi untuk load balancing TCP/UDP berbeda dari konfigurasi HTTP. Alih-alih menggunakan blok `server` dan `location`, kita akan bekerja dengan blok `stream`. Blok ini memungkinkan kita untuk menentukan server upstream yang akan menerima koneksi TCP atau UDP. Misalnya, kita dapat mendefinisikan grup server database, dan Nginx akan mendistribusikan koneksi masuk di antara mereka. Ini tidak hanya meningkatkan ketersediaan tetapi juga meningkatkan kinerja dengan mencegah satu server menjadi bottleneck.

Selanjutnya, kita perlu mempertimbangkan metode load balancing yang akan kita gunakan. Nginx menawarkan beberapa opsi, termasuk round-robin, least_conn, dan ip_hash. Round-robin adalah metode yang paling sederhana, di mana permintaan didistribusikan secara berurutan ke setiap server. Least_conn, di sisi lain, mengirimkan permintaan ke server dengan jumlah koneksi aktif paling sedikit, yang dapat lebih efisien dalam beberapa kasus. Terakhir, ip_hash memastikan bahwa permintaan dari alamat IP yang sama selalu diarahkan ke server yang sama, yang dapat berguna untuk aplikasi yang memerlukan persistensi sesi. Pilihan metode load balancing akan bergantung pada kebutuhan spesifik aplikasi Anda.

Selain itu, kita juga dapat mengonfigurasi pemeriksaan kesehatan untuk server upstream. Ini berarti bahwa Nginx akan secara berkala memeriksa apakah server upstream responsif. Jika server gagal dalam pemeriksaan kesehatan, Nginx akan berhenti mengirimkan permintaan ke server tersebut sampai server tersebut kembali online. Ini memastikan bahwa lalu lintas hanya diarahkan ke server yang sehat, meningkatkan keandalan aplikasi Anda. Pemeriksaan kesehatan dapat dikonfigurasi untuk berbagai protokol, termasuk TCP dan HTTP, memberikan fleksibilitas dalam memantau kesehatan server Anda.

Selain itu, Nginx juga memungkinkan kita untuk mengonfigurasi berbagai parameter untuk mengoptimalkan kinerja load balancing TCP/UDP. Misalnya, kita dapat mengatur batas waktu koneksi, ukuran buffer, dan parameter lainnya untuk menyempurnakan perilaku Nginx. Parameter ini dapat disesuaikan untuk memenuhi kebutuhan spesifik aplikasi Anda, memastikan bahwa Nginx beroperasi dengan efisiensi maksimum. Dengan demikian, Nginx tidak hanya bertindak sebagai load balancer, tetapi juga sebagai alat yang dapat disesuaikan untuk mengoptimalkan kinerja jaringan Anda.

Terakhir, penting untuk dicatat bahwa konfigurasi load balancing TCP/UDP dengan Nginx dapat menjadi proses yang kompleks, dan pemahaman yang menyeluruh tentang protokol dan aplikasi yang Anda gunakan sangat penting. Namun, dengan konfigurasi yang tepat, Nginx dapat menjadi alat yang ampuh untuk meningkatkan ketersediaan, kinerja, dan skalabilitas aplikasi Anda. Dengan demikian, Nginx bukan hanya sekadar server web, tetapi juga merupakan solusi load balancing yang serbaguna dan kuat.

Mengkonfigurasi Nginx Sebagai Load Balancer HTTP

Mari kita mulai perjalanan yang menarik untuk mengubah Nginx menjadi load balancer HTTP yang tangguh. Bayangkan Nginx sebagai kondektur orkestra, yang dengan anggun mengarahkan aliran permintaan masuk ke berbagai server backend, memastikan bahwa setiap instrumen (server) memainkan perannya dengan harmonis. Untuk mencapai orkestrasi yang sempurna ini, kita perlu mengonfigurasi Nginx dengan cermat, dan di sinilah keajaiban dimulai.

Pertama, kita akan menyelami inti konfigurasi Nginx, yaitu blok `upstream`. Blok ini pada dasarnya adalah daftar server backend yang akan didistribusikan oleh Nginx. Bayangkan ini sebagai daftar pemain orkestra, masing-masing dengan alamat IP dan port uniknya. Misalnya, kita dapat mendefinisikan blok `upstream` yang disebut `backend_servers` yang berisi beberapa server web, masing-masing siap untuk menangani permintaan. Dengan cara ini, kita telah meletakkan dasar untuk load balancing.

Selanjutnya, kita perlu memberi tahu Nginx bagaimana menangani permintaan masuk dan mengarahkannya ke server backend yang telah kita definisikan. Di sinilah blok `server` berperan. Dalam blok ini, kita akan menentukan port tempat Nginx akan mendengarkan permintaan masuk, dan yang lebih penting, kita akan menggunakan arahan `proxy_pass` untuk mengarahkan permintaan ini ke blok `upstream` yang telah kita buat sebelumnya. Dengan kata lain, kita memberi tahu Nginx untuk bertindak sebagai perantara, menerima permintaan dan meneruskannya ke salah satu server backend.

Namun, load balancing bukan hanya tentang meneruskan permintaan secara acak. Kita juga perlu mempertimbangkan berbagai algoritma load balancing. Secara default, Nginx menggunakan algoritma round-robin, yang mendistribusikan permintaan secara berurutan ke setiap server backend. Namun, Nginx juga menawarkan algoritma lain, seperti `least_conn`, yang mengarahkan permintaan ke server dengan koneksi aktif paling sedikit, dan `ip_hash`, yang memastikan bahwa permintaan dari alamat IP yang sama selalu diarahkan ke server yang sama. Memilih algoritma yang tepat sangat penting untuk memastikan distribusi beban yang optimal dan kinerja aplikasi.

Selain itu, kita dapat meningkatkan konfigurasi load balancing kita dengan menambahkan pemeriksaan kesehatan. Pemeriksaan kesehatan memungkinkan Nginx untuk secara aktif memantau kesehatan server backend dan secara otomatis menghapus server yang tidak sehat dari rotasi. Ini memastikan bahwa permintaan hanya diarahkan ke server yang berfungsi, meningkatkan keandalan dan ketersediaan aplikasi kita. Dengan kata lain, kita memastikan bahwa orkestra kita hanya terdiri dari pemain yang sehat dan siap untuk tampil.

Selain itu, kita dapat menyempurnakan konfigurasi kita lebih lanjut dengan menambahkan fitur-fitur seperti persistensi sesi. Persistensi sesi memastikan bahwa permintaan dari pengguna yang sama selalu diarahkan ke server backend yang sama, yang sangat penting untuk aplikasi yang bergantung pada sesi pengguna. Ini dapat dicapai dengan menggunakan cookie atau metode lain untuk mengidentifikasi pengguna dan mengarahkannya ke server yang sesuai. Dengan cara ini, kita memastikan bahwa setiap pengguna memiliki pengalaman yang konsisten dan lancar.

Terakhir, penting untuk dicatat bahwa konfigurasi load balancing Nginx dapat disesuaikan dengan kebutuhan spesifik aplikasi kita. Dengan memahami berbagai opsi dan arahan yang tersedia, kita dapat membuat solusi load balancing yang kuat dan efisien yang dapat menangani lalu lintas tinggi dan memastikan ketersediaan aplikasi kita. Dengan demikian, Nginx menjadi lebih dari sekadar server web; ia menjadi load balancer yang tangguh, yang dengan anggun mengarahkan lalu lintas dan memastikan bahwa aplikasi kita berjalan dengan lancar.

Memahami Dasar-Dasar Load Balancing Dengan Nginx

Mari kita mulai perjalanan untuk memahami bagaimana Nginx, server web yang tangguh, dapat berfungsi sebagai load balancer yang andal. Pada intinya, load balancing adalah seni mendistribusikan lalu lintas jaringan atau aplikasi di beberapa server. Bayangkan sebuah restoran yang ramai pada jam makan siang; alih-alih membiarkan satu pelayan kewalahan, Anda akan membagi pelanggan di antara beberapa pelayan, memastikan layanan yang lebih lancar dan efisien. Demikian pula, load balancer Nginx bertindak sebagai pengontrol lalu lintas, mengarahkan permintaan masuk ke berbagai server backend.

Sekarang, mengapa kita membutuhkan load balancing? Nah, bayangkan sebuah situs web yang mengalami lonjakan lalu lintas yang tiba-tiba. Tanpa load balancing, satu server mungkin akan kewalahan, menyebabkan waktu muat yang lambat, kesalahan, atau bahkan kegagalan total. Load balancing, di sisi lain, memastikan bahwa tidak ada satu server pun yang dibebani secara berlebihan, sehingga meningkatkan kinerja dan ketersediaan aplikasi Anda. Selain itu, dengan mendistribusikan beban, Anda dapat meningkatkan toleransi kesalahan. Jika satu server gagal, load balancer akan secara otomatis mengalihkan lalu lintas ke server yang tersisa, memastikan layanan tanpa gangguan.

Nginx, dengan arsitekturnya yang ringan dan efisien, sangat cocok untuk tugas load balancing. Ini dapat menangani sejumlah besar koneksi secara bersamaan, menjadikannya pilihan yang sangat baik untuk aplikasi web skala besar. Selain itu, Nginx menawarkan berbagai algoritma load balancing, memungkinkan Anda untuk memilih metode yang paling sesuai dengan kebutuhan spesifik Anda. Misalnya, algoritma round-robin mendistribusikan permintaan secara berurutan ke setiap server, sementara algoritma least-connected mengarahkan permintaan ke server dengan koneksi aktif paling sedikit.

Selain itu, Nginx menyediakan fitur-fitur canggih seperti pemeriksaan kesehatan, yang memungkinkan untuk memantau kesehatan server backend. Jika server gagal merespons, Nginx akan secara otomatis menghapusnya dari rotasi, mencegah pengguna diarahkan ke server yang tidak berfungsi. Ini memastikan bahwa pengguna selalu diarahkan ke server yang sehat, meningkatkan pengalaman pengguna secara keseluruhan. Selain itu, Nginx mendukung berbagai protokol, termasuk HTTP, HTTPS, dan TCP, menjadikannya solusi load balancing yang serbaguna untuk berbagai aplikasi.

Selanjutnya, konfigurasi Nginx sebagai load balancer relatif mudah. Ini melibatkan penentuan server backend dan algoritma load balancing yang diinginkan dalam file konfigurasi Nginx. Dengan beberapa baris kode, Anda dapat mengubah Nginx menjadi load balancer yang kuat, mendistribusikan lalu lintas dengan lancar di beberapa server. Selain itu, Nginx menawarkan fleksibilitas untuk mengonfigurasi berbagai parameter, seperti batas waktu dan ukuran buffer, memungkinkan Anda untuk menyempurnakan kinerja load balancer Anda.

Singkatnya, load balancing adalah komponen penting dari infrastruktur aplikasi modern, dan Nginx adalah pilihan yang sangat baik untuk tugas ini. Dengan kemampuannya untuk mendistribusikan lalu lintas, meningkatkan kinerja, dan memastikan ketersediaan tinggi, Nginx adalah alat yang berharga untuk setiap pengembang atau administrator sistem. Dengan memahami dasar-dasar load balancing dengan Nginx, Anda dapat membangun aplikasi yang lebih andal dan terukur yang dapat menangani permintaan pengguna yang terus meningkat.Mengkonfigurasi Nginx sebagai load balancer melibatkan pengaturan Nginx untuk mendistribusikan lalu lintas jaringan di antara beberapa server backend. Ini meningkatkan ketersediaan, skalabilitas, dan kinerja aplikasi web. Konfigurasi melibatkan penentuan server upstream, metode load balancing (misalnya, round-robin, least_conn, ip_hash), dan pengaturan kesehatan server.

Menggunakan HAProxy Untuk Load Balancing

Untuk mencapai load balancing yang efektif pada VPS Linux, HAProxy muncul sebagai solusi yang kuat dan serbaguna. Perangkat lunak open-source ini, yang dikenal karena kinerja dan keandalannya, bertindak sebagai load balancer yang efisien, mendistribusikan lalu lintas jaringan masuk di antara beberapa server backend. Dengan demikian, HAProxy memastikan bahwa tidak ada satu server pun yang kewalahan, sehingga meningkatkan ketersediaan dan responsivitas aplikasi Anda.

Untuk memulai, langkah pertama melibatkan instalasi HAProxy pada VPS Anda. Ini biasanya dapat dilakukan melalui manajer paket sistem operasi Anda, seperti apt pada sistem berbasis Debian atau Ubuntu, atau yum pada sistem berbasis CentOS atau RHEL. Setelah instalasi selesai, langkah selanjutnya adalah mengonfigurasi HAProxy untuk memenuhi kebutuhan spesifik Anda. Konfigurasi ini dilakukan melalui file konfigurasi, biasanya terletak di /etc/haproxy/haproxy.cfg.

File konfigurasi ini adalah jantung dari operasi HAProxy. Di dalamnya, Anda menentukan berbagai parameter, termasuk server frontend yang mendengarkan koneksi masuk, server backend yang menangani permintaan, dan algoritma load balancing yang digunakan. Misalnya, Anda dapat mengonfigurasi HAProxy untuk mendengarkan port 80 atau 443 untuk lalu lintas HTTP atau HTTPS, dan kemudian meneruskan permintaan ini ke beberapa server web backend. Selain itu, Anda dapat memilih dari berbagai algoritma load balancing, seperti round-robin, leastconn, atau source, tergantung pada persyaratan aplikasi Anda.

Selain itu, HAProxy menawarkan berbagai fitur canggih yang meningkatkan fungsionalitasnya. Ini termasuk pemeriksaan kesehatan, yang memungkinkan HAProxy untuk secara otomatis mendeteksi dan menghapus server yang tidak sehat dari rotasi, memastikan bahwa hanya server yang berfungsi yang menerima lalu lintas. Selain itu, HAProxy mendukung persistensi sesi, yang memastikan bahwa permintaan dari pengguna yang sama selalu diarahkan ke server backend yang sama, yang penting untuk aplikasi yang bergantung pada status sesi.

Selain itu, HAProxy dapat dikonfigurasi untuk menangani berbagai protokol, termasuk HTTP, HTTPS, TCP, dan UDP. Fleksibilitas ini menjadikannya pilihan yang cocok untuk berbagai aplikasi, mulai dari situs web sederhana hingga sistem yang kompleks. Selain itu, HAProxy dapat diintegrasikan dengan alat pemantauan, memungkinkan Anda untuk melacak kinerja dan kesehatan server Anda secara real-time.

Selain itu, penting untuk dicatat bahwa konfigurasi HAProxy yang tepat sangat penting untuk kinerja optimal. Ini melibatkan pemahaman yang cermat tentang persyaratan aplikasi Anda dan konfigurasi HAProxy yang sesuai. Ini mungkin termasuk menyetel parameter seperti batas koneksi, waktu habis, dan ukuran buffer. Selain itu, Anda harus secara teratur memantau kinerja HAProxy dan membuat penyesuaian yang diperlukan untuk memastikan bahwa ia terus beroperasi secara efisien.

Singkatnya, HAProxy adalah alat yang ampuh untuk load balancing pada VPS Linux. Dengan konfigurasi yang tepat, ini dapat meningkatkan ketersediaan, responsivitas, dan skalabilitas aplikasi Anda secara signifikan. Dengan memahami fitur dan opsi konfigurasinya, Anda dapat memanfaatkan HAProxy untuk membuat infrastruktur yang kuat dan andal.

Memantau dan Mengelola Load Balancing

Setelah load balancer dikonfigurasi dan beroperasi, langkah selanjutnya yang penting adalah memantau dan mengelolanya secara efektif. Pemantauan yang berkelanjutan sangat penting untuk memastikan bahwa load balancer berfungsi sebagaimana mestinya dan bahwa aplikasi Anda tetap tersedia dan responsif. Ini melibatkan pelacakan berbagai metrik, seperti penggunaan CPU dan memori server backend, lalu lintas jaringan, dan waktu respons aplikasi. Dengan memantau metrik ini, Anda dapat mengidentifikasi potensi masalah sebelum menyebabkan gangguan yang signifikan. Misalnya, lonjakan penggunaan CPU pada server backend tertentu dapat mengindikasikan bahwa server tersebut mengalami kelebihan beban dan mungkin perlu dikeluarkan dari rotasi hingga masalahnya teratasi.

Selain itu, pemantauan juga dapat membantu Anda mengoptimalkan konfigurasi load balancing Anda. Dengan menganalisis data kinerja, Anda dapat mengidentifikasi pola dan tren yang dapat menginformasikan keputusan tentang cara mendistribusikan lalu lintas dengan lebih baik di antara server backend Anda. Misalnya, jika Anda melihat bahwa server tertentu secara konsisten menangani lebih banyak lalu lintas daripada yang lain, Anda mungkin perlu menyesuaikan algoritma load balancing atau menambahkan lebih banyak server ke kumpulan backend. Selain itu, pemantauan dapat membantu Anda mengidentifikasi dan mengatasi masalah kinerja aplikasi. Jika Anda melihat bahwa waktu respons aplikasi lambat, Anda dapat menggunakan data pemantauan untuk menentukan apakah masalahnya ada pada load balancer, server backend, atau aplikasi itu sendiri.

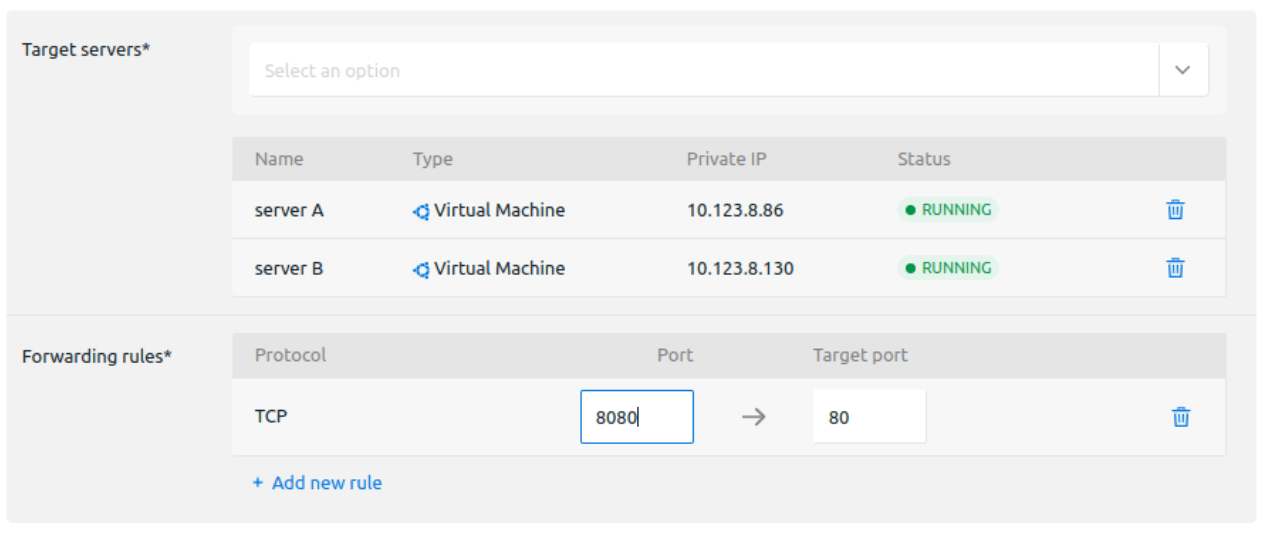

Selanjutnya, pengelolaan load balancer melibatkan berbagai tugas, termasuk menambahkan atau menghapus server backend, memperbarui konfigurasi load balancer, dan memecahkan masalah. Saat aplikasi Anda berkembang, Anda mungkin perlu menambahkan lebih banyak server backend untuk menangani peningkatan lalu lintas. Proses ini biasanya melibatkan konfigurasi server baru dan menambahkannya ke kumpulan backend load balancer. Demikian pula, Anda mungkin perlu menghapus server dari kumpulan backend jika server tersebut tidak lagi diperlukan atau jika server tersebut mengalami masalah. Selain itu, Anda mungkin perlu memperbarui konfigurasi load balancer untuk menyesuaikan dengan perubahan pada aplikasi atau infrastruktur Anda. Ini mungkin melibatkan perubahan algoritma load balancing, menambahkan aturan baru, atau memperbarui sertifikat SSL.

Selain itu, pemecahan masalah adalah bagian penting dari pengelolaan load balancer. Jika Anda mengalami masalah dengan load balancer, Anda perlu dapat mengidentifikasi penyebab masalah dan mengambil tindakan korektif. Ini mungkin melibatkan pemeriksaan log load balancer, menganalisis data pemantauan, dan menguji konfigurasi load balancer. Selain itu, Anda mungkin perlu berkonsultasi dengan dokumentasi load balancer atau mencari bantuan dari penyedia load balancer. Dengan demikian, pemantauan dan pengelolaan load balancer adalah proses berkelanjutan yang memerlukan perhatian dan pemeliharaan yang berkelanjutan. Dengan memantau kinerja load balancer dan mengelolanya secara efektif, Anda dapat memastikan bahwa aplikasi Anda tetap tersedia, responsif, dan andal.

Kesimpulan

Untuk mengimplementasikan load balancing pada lingkungan VPS Linux, Nginx muncul sebagai pilihan yang kuat dan serbaguna. Kemampuannya untuk menangani sejumlah besar koneksi secara efisien, ditambah dengan konfigurasi yang fleksibel, menjadikannya pilihan yang sangat baik untuk mendistribusikan lalu lintas di antara beberapa server backend. Oleh karena itu, langkah pertama dalam proses ini melibatkan instalasi Nginx pada VPS yang ditunjuk sebagai load balancer. Ini biasanya dapat dicapai melalui manajer paket sistem operasi, seperti apt pada sistem berbasis Debian atau Ubuntu, atau yum pada sistem berbasis CentOS atau RHEL. Setelah instalasi, konfigurasi Nginx perlu disesuaikan untuk memenuhi persyaratan load balancing tertentu.

Selanjutnya, konfigurasi load balancing Nginx berpusat pada modifikasi file konfigurasi utama, biasanya terletak di /etc/nginx/nginx.conf atau di direktori /etc/nginx/conf.d/. Di dalam file ini, blok upstream didefinisikan, yang menentukan server backend yang akan didistribusikan lalu lintas. Setiap server backend diidentifikasi dengan alamat IP atau nama domain dan portnya. Selain itu, berbagai algoritma load balancing dapat ditentukan dalam blok upstream, seperti round-robin, least_conn, atau ip_hash. Algoritma round-robin, misalnya, mendistribusikan permintaan secara berurutan ke setiap server backend, sedangkan least_conn mengarahkan permintaan ke server dengan koneksi aktif paling sedikit. Pilihan algoritma bergantung pada kebutuhan spesifik aplikasi dan karakteristik server backend.

Setelah blok upstream dikonfigurasi, blok server perlu dimodifikasi untuk mengarahkan lalu lintas ke server backend yang ditentukan. Ini melibatkan penggunaan arahan proxy_pass dalam blok location untuk meneruskan permintaan ke blok upstream yang sesuai. Selain itu, arahan lain seperti proxy_set_header dapat digunakan untuk memodifikasi header permintaan sebelum diteruskan ke server backend. Ini dapat mencakup header seperti Host, X-Real-IP, dan X-Forwarded-For, yang penting untuk memastikan bahwa server backend dapat mengidentifikasi asal permintaan dengan benar.

Selain itu, penting untuk mengonfigurasi pemeriksaan kesehatan untuk memastikan bahwa Nginx hanya mengarahkan lalu lintas ke server backend yang sehat. Ini dapat dicapai dengan menggunakan arahan health_check dalam blok upstream. Pemeriksaan kesehatan dapat dikonfigurasi untuk mengirim permintaan HTTP ke server backend dan memeriksa kode respons. Jika server backend gagal dalam pemeriksaan kesehatan, Nginx akan berhenti mengarahkannya lalu lintas hingga kembali sehat. Ini membantu memastikan ketersediaan dan keandalan aplikasi.

Terakhir, setelah konfigurasi Nginx selesai, penting untuk menguji konfigurasi secara menyeluruh untuk memastikan bahwa load balancing berfungsi seperti yang diharapkan. Ini dapat dilakukan dengan mengirimkan permintaan ke load balancer dan memantau distribusi lalu lintas di antara server backend. Selain itu, log Nginx dapat diperiksa untuk setiap kesalahan atau masalah yang mungkin terjadi. Dengan mengikuti langkah-langkah ini, Nginx dapat dikonfigurasi secara efektif sebagai load balancer, mendistribusikan lalu lintas di antara beberapa server backend dan meningkatkan ketersediaan dan skalabilitas aplikasi.

Load balancing pada VPS Linux dapat dicapai dengan berbagai metode, termasuk menggunakan Nginx, HAProxy, atau solusi berbasis cloud. Konfigurasi melibatkan pengaturan server backend, konfigurasi load balancer, dan pemantauan kesehatan server. Pemilihan metode dan konfigurasi yang tepat bergantung pada kebutuhan spesifik aplikasi dan infrastruktur.