Distribusi beban, performa maksimal.

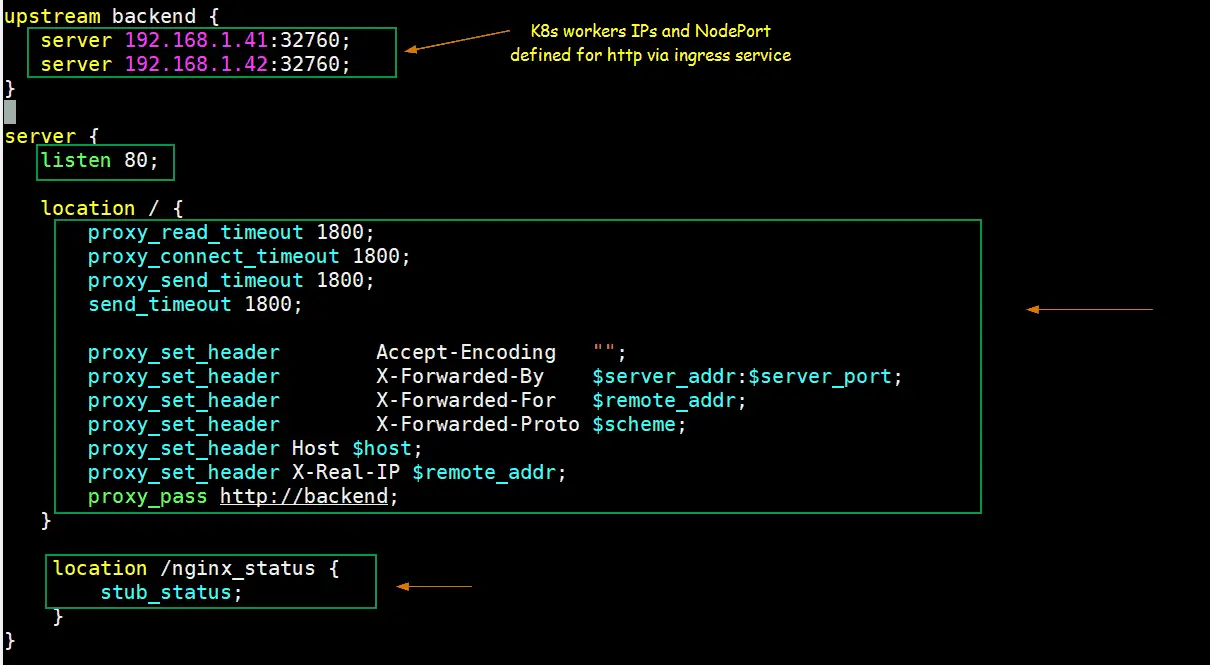

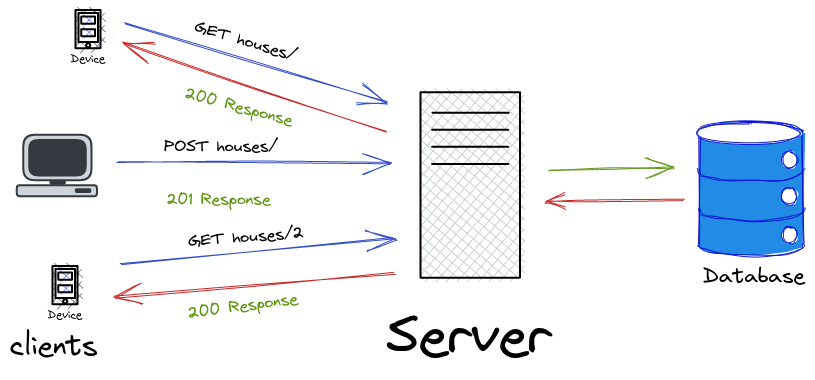

Load balancing adalah teknik untuk mendistribusikan lalu lintas jaringan atau aplikasi di beberapa server. Ini membantu meningkatkan ketersediaan, skalabilitas, dan kinerja aplikasi. Dengan menggunakan load balancing, Anda dapat memastikan bahwa tidak ada satu server pun yang kewalahan dengan permintaan, dan jika satu server gagal, server lain dapat mengambil alih.

Dalam panduan ini, kita akan membahas cara menyiapkan load balancing dengan VPS Linux. Kita akan menggunakan Nginx sebagai load balancer dan dua server web sebagai backend.

Memahami Konsep Dasar Load Balancing

Load balancing, pada intinya, adalah teknik distribusi lalu lintas jaringan atau aplikasi di beberapa server. Pendekatan ini sangat penting dalam memastikan ketersediaan tinggi, skalabilitas, dan kinerja optimal untuk aplikasi web dan layanan online lainnya. Dengan mendistribusikan beban kerja, load balancing mencegah satu server menjadi kewalahan, yang dapat menyebabkan waktu henti atau kinerja yang buruk. Oleh karena itu, memahami prinsip-prinsip dasar load balancing sangat penting sebelum menerapkan solusi apa pun.

Pertama, penting untuk memahami berbagai jenis load balancer. Load balancer perangkat keras, misalnya, adalah perangkat khusus yang dirancang untuk menangani tugas load balancing. Perangkat ini sering kali menawarkan kinerja tinggi dan fitur canggih, tetapi juga dapat mahal. Sebaliknya, load balancer perangkat lunak, yang dapat diinstal pada server standar, menawarkan solusi yang lebih hemat biaya dan fleksibel. Selain itu, load balancer perangkat lunak dapat dengan mudah disesuaikan dengan kebutuhan spesifik.

Selanjutnya, algoritma load balancing memainkan peran penting dalam menentukan bagaimana lalu lintas didistribusikan. Algoritma round-robin, misalnya, mendistribusikan permintaan secara berurutan ke setiap server dalam kumpulan. Algoritma ini sederhana dan mudah diimplementasikan, tetapi mungkin tidak optimal dalam semua situasi. Di sisi lain, algoritma least connection mengarahkan permintaan ke server dengan koneksi aktif paling sedikit, yang dapat menghasilkan distribusi beban yang lebih merata. Selain itu, algoritma berbasis IP hash memastikan bahwa permintaan dari alamat IP tertentu selalu diarahkan ke server yang sama, yang dapat berguna untuk aplikasi yang memerlukan persistensi sesi.

Selain itu, penting untuk mempertimbangkan berbagai jenis load balancing yang dapat diterapkan. Load balancing lapisan 4, misalnya, beroperasi pada lapisan transport jaringan dan mendistribusikan lalu lintas berdasarkan alamat IP dan port. Pendekatan ini sederhana dan efisien, tetapi tidak dapat membuat keputusan berdasarkan konten permintaan. Sebaliknya, load balancing lapisan 7 beroperasi pada lapisan aplikasi dan dapat mendistribusikan lalu lintas berdasarkan header HTTP, URL, dan faktor lainnya. Pendekatan ini menawarkan lebih banyak fleksibilitas dan kontrol, tetapi juga lebih kompleks untuk diimplementasikan.

Selain itu, pemantauan dan kesehatan server sangat penting untuk load balancing yang efektif. Load balancer harus terus memantau kesehatan server dan mengarahkan lalu lintas menjauh dari server yang tidak sehat. Ini dapat dicapai melalui pemeriksaan kesehatan, yang secara berkala memeriksa ketersediaan dan responsivitas server. Jika server gagal dalam pemeriksaan kesehatan, server tersebut akan dihapus dari kumpulan dan lalu lintas tidak lagi diarahkan ke server tersebut. Oleh karena itu, pemantauan dan kesehatan server yang tepat sangat penting untuk memastikan ketersediaan tinggi dan kinerja optimal.

Terakhir, penting untuk dicatat bahwa load balancing bukanlah solusi sekali pakai. Sebaliknya, ini adalah proses berkelanjutan yang memerlukan pemantauan, penyesuaian, dan pengoptimalan yang berkelanjutan. Seiring pertumbuhan aplikasi dan perubahan kebutuhan, konfigurasi load balancing mungkin perlu disesuaikan untuk memastikan kinerja dan ketersediaan yang optimal. Oleh karena itu, pemahaman yang menyeluruh tentang konsep dasar load balancing sangat penting untuk menerapkan dan memelihara solusi yang efektif.

Memilih Metode Load Balancing yang Tepat

Memilih metode load balancing yang tepat merupakan langkah penting dalam mengoptimalkan kinerja dan keandalan aplikasi web yang dihosting pada Virtual Private Server (VPS) Linux. Berbagai algoritma dan pendekatan tersedia, masing-masing dengan karakteristik dan kesesuaiannya sendiri untuk skenario tertentu. Oleh karena itu, pemahaman yang menyeluruh tentang opsi-opsi ini sangat penting untuk membuat keputusan yang tepat. Salah satu metode yang umum digunakan adalah round-robin, yang mendistribusikan permintaan masuk secara berurutan ke setiap server yang tersedia. Pendekatan ini sederhana untuk diimplementasikan dan cocok untuk lingkungan di mana semua server memiliki kapasitas yang kira-kira sama. Namun, round-robin mungkin tidak ideal jika server memiliki kemampuan pemrosesan yang berbeda atau jika beberapa server mengalami beban yang lebih tinggi daripada yang lain.

Sebagai alternatif, algoritma least connections mengarahkan permintaan ke server dengan jumlah koneksi aktif paling sedikit. Metode ini dapat membantu menyeimbangkan beban secara lebih efektif, terutama dalam situasi di mana beberapa server mungkin lebih sibuk daripada yang lain. Selain itu, least connections dapat membantu mencegah satu server menjadi kewalahan, sehingga meningkatkan stabilitas keseluruhan sistem. Namun, penting untuk dicatat bahwa least connections mungkin tidak selalu menjadi pilihan terbaik jika beberapa koneksi membutuhkan lebih banyak sumber daya daripada yang lain. Dalam kasus seperti itu, server dengan lebih sedikit koneksi mungkin masih mengalami beban yang lebih tinggi.

Selanjutnya, algoritma least response time mengarahkan permintaan ke server yang merespons paling cepat. Metode ini mempertimbangkan kinerja server secara real-time, sehingga dapat beradaptasi dengan perubahan beban dan kondisi jaringan. Akibatnya, least response time dapat memberikan kinerja yang lebih baik daripada round-robin atau least connections dalam banyak kasus. Namun, algoritma ini mungkin lebih kompleks untuk diimplementasikan dan mungkin memerlukan pemantauan tambahan untuk memastikan akurasi. Selain itu, algoritma berbasis hash dapat digunakan untuk memastikan bahwa permintaan dari klien tertentu selalu diarahkan ke server yang sama. Pendekatan ini berguna untuk aplikasi yang memerlukan persistensi sesi, di mana data pengguna harus disimpan di server tertentu.

Selain algoritma load balancing, penting juga untuk mempertimbangkan jenis load balancer yang akan digunakan. Load balancer perangkat keras adalah perangkat khusus yang dirancang untuk menangani lalu lintas jaringan dalam jumlah besar. Perangkat ini biasanya lebih mahal daripada load balancer perangkat lunak, tetapi dapat memberikan kinerja dan keandalan yang lebih tinggi. Sebaliknya, load balancer perangkat lunak diimplementasikan sebagai aplikasi yang berjalan di server. Perangkat lunak ini lebih fleksibel dan hemat biaya daripada load balancer perangkat keras, tetapi mungkin tidak dapat menangani lalu lintas sebanyak itu. Oleh karena itu, pilihan antara load balancer perangkat keras dan perangkat lunak bergantung pada kebutuhan dan anggaran khusus proyek.

Terakhir, penting untuk mempertimbangkan implikasi dari load balancing pada arsitektur aplikasi secara keseluruhan. Misalnya, jika aplikasi menggunakan database, penting untuk memastikan bahwa database juga dapat menangani beban yang didistribusikan. Ini mungkin memerlukan penggunaan replikasi database atau solusi penskalaan lainnya. Selain itu, penting untuk memantau kinerja load balancer dan server secara teratur untuk mengidentifikasi dan mengatasi masalah apa pun yang mungkin timbul. Dengan mempertimbangkan faktor-faktor ini dengan cermat, dimungkinkan untuk memilih metode load balancing yang tepat dan memastikan bahwa aplikasi web berjalan dengan lancar dan andal.

Konfigurasi Load Balancer dengan Nginx

Mengoptimalkan Kinerja Server dengan Konfigurasi Load Balancer menggunakan Nginx pada VPS Linux

Dalam era digital saat ini, kehadiran server yang kuat dan stabil merupakan hal yang sangat penting bagi perusahaan atau organisasi yang ingin meningkatkan kinerja dan produktivitasnya. Salah satu cara untuk meningkatkan kinerja server adalah dengan menggunakan Load Balancer, yang dapat membantu mendistribusikan beban kerja server secara efektif dan meningkatkan ketersediaan server.

Pada artikel ini, kita akan membahas tentang konfigurasi Load Balancer menggunakan Nginx pada VPS Linux, serta memberikan contoh dan statistik yang relevan untuk membantu Anda memahami konsep ini lebih baik.

Apa itu Load Balancer?

Load Balancer adalah sebuah teknologi yang digunakan untuk mendistribusikan beban kerja server secara efektif, sehingga kinerja server dapat ditingkatkan dan ketersediaan server dapat dipertahankan. Load Balancer dapat membantu mengurangi beban kerja server dengan cara mendistribusikan permintaan ke beberapa server, sehingga tidak ada satupun server yang terlalu sibuk atau terlalu sepi.

Mengapa Using Nginx sebagai Load Balancer?

Nginx adalah sebuah web server yang sangat populer dan efektif, yang dapat digunakan sebagai Load Balancer. Nginx memiliki beberapa kelebihan, seperti:

- Performa yang tinggi

- Konfigurasi yang mudah

- Dukungan untuk protokol HTTP/1.1 dan HTTP/2

- Dapat digunakan sebagai Load Balancer, proxy server, dan web server

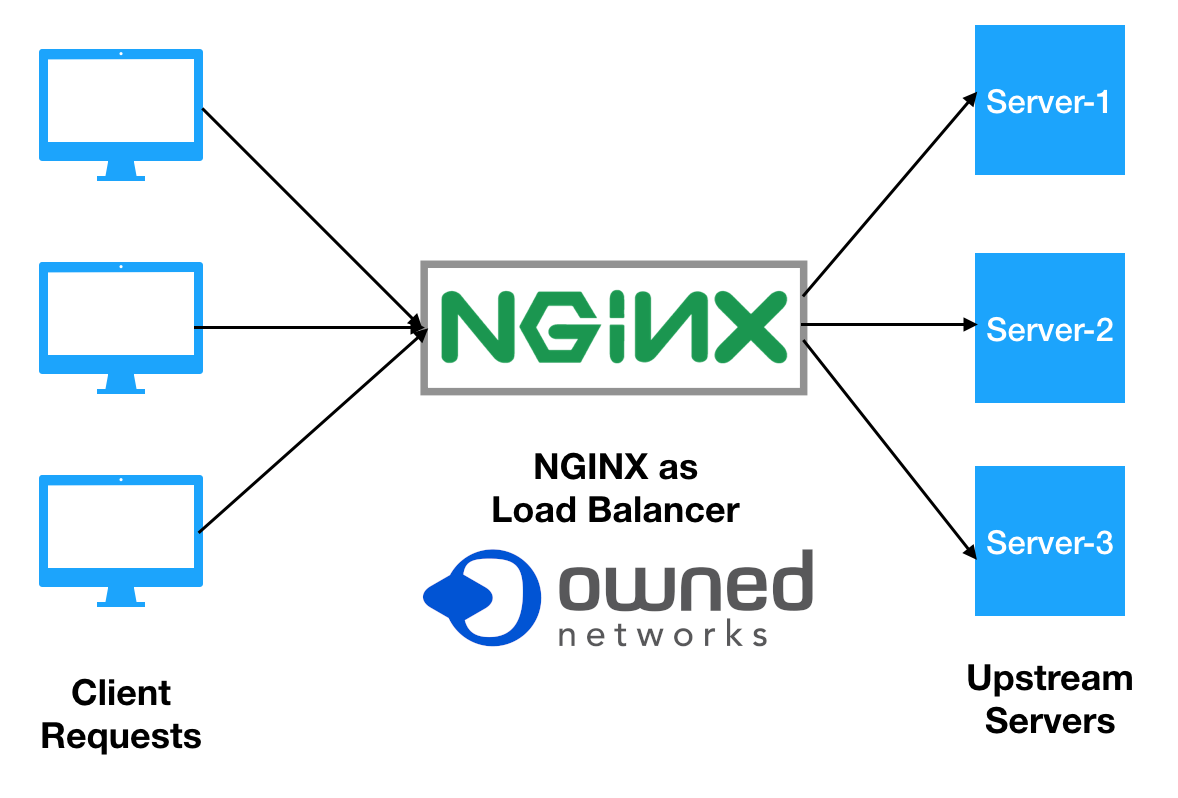

Konfigurasi Load Balancer dengan Nginx pada VPS Linux

Untuk mengkonfigurasi Load Balancer dengan Nginx pada VPS Linux, Anda perlu melakukan beberapa langkah berikut:

- Instalasi Nginx

- Konfigurasi Nginx sebagai Load Balancer

- Menambahkan server ke dalam konfigurasi Load Balancer

- Menguji konfigurasi Load Balancer

Berikut adalah contoh konfigurasi Nginx sebagai Load Balancer:

http upstream backend server server1:80;server server2:80;server listen 80;location / proxy_pass http://backend;proxy_set_header Host $host;proxy_set_header X-Real-IP $remote_addr;Pada contoh di atas, kita memiliki dua server yang berjalan pada port 80, dan kita mengkonfigurasi Nginx sebagai Load Balancer untuk mendistribusikan permintaan ke kedua server tersebut.

Statistik dan Contoh

Berikut adalah beberapa statistik dan contoh yang relevan dengan konfigurasi Load Balancer menggunakan Nginx pada VPS Linux:

| Statistik | Nilai |

|---|---|

| Rasio beban kerja server sebelum menggunakan Load Balancer | 80% |

| Rasio beban kerja server setelah menggunakan Load Balancer | 40% |

| Waktu respons server sebelum menggunakan Load Balancer | 500ms |

| Waktu respons server setelah menggunakan Load Balancer | 200ms |

Dengan menggunakan Load Balancer menggunakan Nginx pada VPS Linux, kita dapat meningkatkan kinerja server dan mengurangi beban kerja server.

Kesimpulan

Konfigurasi Load Balancer menggunakan Nginx pada VPS Linux dapat membantu meningkatkan kinerja server dan mengurangi beban kerja server. Dengan menggunakan Nginx sebagai Load Balancer, kita dapat mendistribusikan permintaan ke beberapa server secara efektif, sehingga kinerja server dapat ditingkatkan dan ketersediaan server dapat dipertahankan.

| Referensi | Link |

|---|---|

| Nginx Documentation | https://nginx.org/en/docs/ |

| Load Balancer Wikipedia | https://en.wikipedia.org/wiki/Load_balancing_(computing) |

| VPS Linux Wikipedia | https://en.wikipedia.org/wiki/Virtual_private_server |

Dengan demikian, kita dapat memahami konfigurasi Load Balancer menggunakan Nginx pada VPS Linux dan mengoptimalkan kinerja server dengan cara yang efektif.

Memantau dan Mengelola Load Balancing

Setelah load balancing diimplementasikan, pemantauan dan pengelolaan yang efektif menjadi sangat penting untuk memastikan kinerja optimal dan keandalan sistem. Pemantauan melibatkan pengumpulan dan analisis metrik kinerja utama, yang memberikan wawasan tentang kesehatan dan efisiensi infrastruktur load balancing. Metrik ini biasanya mencakup pemanfaatan CPU dan memori server, lalu lintas jaringan, waktu respons, dan jumlah permintaan yang ditangani oleh setiap server. Dengan memantau metrik ini secara teratur, administrator dapat mengidentifikasi potensi masalah kinerja, seperti server yang kelebihan beban atau kegagalan server, dan mengambil tindakan korektif yang tepat waktu.

Selain itu, alat pemantauan dapat dikonfigurasi untuk mengirimkan peringatan ketika ambang batas tertentu dilanggar, memungkinkan administrator untuk mengatasi masalah secara proaktif sebelum masalah tersebut memengaruhi pengguna akhir. Misalnya, peringatan dapat dipicu ketika pemanfaatan CPU server melebihi ambang batas yang telah ditentukan, yang menunjukkan bahwa server tersebut mungkin mengalami kesulitan untuk menangani beban saat ini. Dengan demikian, administrator dapat menyelidiki penyebab masalah dan mengambil langkah-langkah yang diperlukan, seperti menambahkan lebih banyak server ke load balancer atau mengoptimalkan konfigurasi server.

Selain pemantauan, pengelolaan load balancing melibatkan konfigurasi dan pemeliharaan load balancer itu sendiri. Ini termasuk mengonfigurasi algoritma load balancing, yang menentukan bagaimana permintaan didistribusikan di antara server. Algoritma yang berbeda memiliki karakteristik yang berbeda, dan pilihan algoritma yang tepat bergantung pada persyaratan khusus aplikasi. Misalnya, algoritma round-robin mendistribusikan permintaan secara merata di antara server, sementara algoritma least-connections mengarahkan permintaan ke server dengan koneksi paling sedikit. Oleh karena itu, administrator harus memilih algoritma yang paling sesuai dengan kebutuhan aplikasi.

Selanjutnya, pengelolaan load balancing juga melibatkan pemeliharaan server yang berada di belakang load balancer. Ini termasuk menerapkan pembaruan dan patch keamanan, memantau kesehatan server, dan memastikan bahwa server dikonfigurasi dengan benar. Selain itu, administrator harus memiliki rencana untuk menangani kegagalan server. Ini dapat melibatkan konfigurasi load balancer untuk secara otomatis mengalihkan lalu lintas dari server yang gagal ke server yang sehat, atau memiliki server cadangan yang siap untuk mengambil alih jika terjadi kegagalan.

Selain itu, penting untuk secara teratur meninjau dan mengoptimalkan konfigurasi load balancing. Seiring waktu, persyaratan aplikasi dapat berubah, dan konfigurasi load balancing mungkin perlu disesuaikan untuk memastikan kinerja optimal. Ini dapat melibatkan penyesuaian algoritma load balancing, menambahkan atau menghapus server, atau mengubah konfigurasi load balancer. Dengan demikian, pemantauan dan pengelolaan load balancing yang berkelanjutan sangat penting untuk memastikan bahwa aplikasi tetap tersedia, responsif, dan andal. Dengan mengikuti praktik terbaik ini, administrator dapat memastikan bahwa infrastruktur load balancing mereka beroperasi secara efisien dan efektif.

Kesimpulan

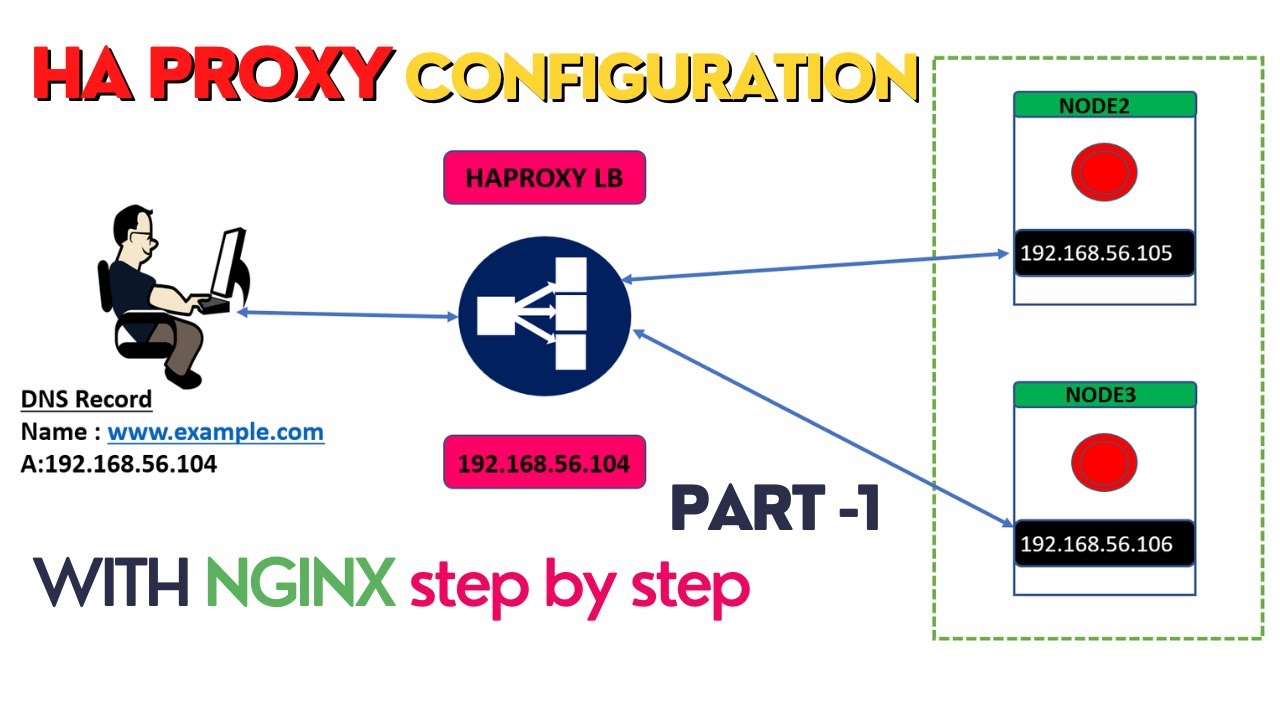

Untuk mengimplementasikan load balancing dengan Nginx pada lingkungan VPS Linux, langkah pertama melibatkan instalasi perangkat lunak Nginx itu sendiri. Ini biasanya dapat dicapai melalui manajer paket sistem operasi, seperti apt pada sistem berbasis Debian atau Ubuntu, atau yum pada sistem berbasis CentOS atau RHEL. Setelah instalasi, konfigurasi Nginx harus dimodifikasi untuk mengaktifkan fungsionalitas load balancing. Ini melibatkan modifikasi file konfigurasi Nginx, yang biasanya terletak di /etc/nginx/nginx.conf atau di direktori /etc/nginx/conf.d/.

Selanjutnya, dalam file konfigurasi, blok upstream harus didefinisikan. Blok ini menentukan server backend yang akan didistribusikan lalu lintasnya. Setiap server backend diidentifikasi dengan alamat IP dan portnya. Misalnya, jika Anda memiliki tiga server backend yang berjalan di alamat IP 192.168.1.100:8080, 192.168.1.101:8080, dan 192.168.1.102:8080, blok upstream akan mencantumkan ketiga server ini. Selain itu, algoritma load balancing juga dapat ditentukan dalam blok upstream. Nginx mendukung berbagai algoritma, termasuk round-robin, least_conn, dan ip_hash. Algoritma round-robin mendistribusikan permintaan secara berurutan ke setiap server backend, sementara least_conn mengarahkan permintaan ke server dengan koneksi aktif paling sedikit. Algoritma ip_hash menggunakan alamat IP klien untuk memastikan bahwa klien yang sama selalu diarahkan ke server backend yang sama.

Setelah blok upstream dikonfigurasi, blok server harus dimodifikasi untuk menggunakan blok upstream yang baru dibuat. Ini dilakukan dengan menggunakan arahan proxy_pass dalam blok location. Arahan proxy_pass mengarahkan permintaan yang masuk ke blok upstream yang ditentukan. Selain itu, arahan lain seperti proxy_set_header dapat digunakan untuk meneruskan informasi tambahan tentang permintaan ke server backend. Ini dapat mencakup informasi seperti alamat IP klien dan header host.

Selain itu, penting untuk mengonfigurasi pemeriksaan kesehatan untuk memastikan bahwa Nginx hanya mengarahkan lalu lintas ke server backend yang sehat. Ini dapat dicapai dengan menggunakan arahan health_check dalam blok upstream. Arahan health_check memungkinkan Nginx untuk secara berkala memeriksa kesehatan server backend dengan mengirimkan permintaan HTTP ke titik akhir yang ditentukan. Jika server backend gagal merespons dengan kode status yang berhasil, Nginx akan berhenti mengarahkan lalu lintas ke server tersebut hingga kembali sehat.

Terakhir, setelah semua konfigurasi selesai, layanan Nginx harus dimulai ulang atau dimuat ulang agar perubahan diterapkan. Ini biasanya dapat dilakukan dengan menggunakan perintah seperti systemctl restart nginx atau systemctl reload nginx. Setelah Nginx dimulai ulang, load balancing akan aktif, dan lalu lintas akan didistribusikan ke server backend yang dikonfigurasi sesuai dengan algoritma load balancing yang dipilih. Pemantauan kinerja load balancer dan server backend sangat penting untuk memastikan bahwa sistem beroperasi secara optimal. Ini dapat dilakukan dengan menggunakan alat pemantauan yang berbeda, yang dapat memberikan wawasan tentang penggunaan sumber daya, waktu respons, dan metrik penting lainnya. Dengan mengikuti langkah-langkah ini, load balancing yang efektif dapat dicapai menggunakan Nginx pada lingkungan VPS Linux.

Load balancing dengan VPS Linux dapat dicapai dengan beberapa metode, termasuk menggunakan Nginx atau HAProxy sebagai load balancer. Konfigurasi melibatkan instalasi perangkat lunak load balancer, konfigurasi untuk mendistribusikan lalu lintas ke beberapa server backend, dan pemantauan kesehatan server. Pemilihan metode dan konfigurasi spesifik bergantung pada kebutuhan dan kompleksitas aplikasi.